如果您经营一个网站,则可能听说过robots.txt文件(或“机器人排除标准")。无论您是否拥有,都该学习一下了,因为这个简单的文本文件是您网站的重要组成部分。它看起来似乎微不足道,但您可能会对它的重要性感到惊讶。

让我们看一下robots.txt文件的含义,作用以及如何正确设置它。网站。

什么是robots.txt文件?

要了解robots.txt文件的工作原理,您需要对搜索引擎有所了解。简短的版本是它们发出“爬虫",这些爬虫是在互联网上搜索信息的程序。然后,他们存储了一些信息,以便以后引导人们访问。

这些爬虫(也称为“机器人"或“蜘蛛")从数十亿个网站中查找页面。搜索引擎为他们提供了前往目的地的方向,但是各个网站也可以与漫游器进行交流,并告诉他们应该查看哪些页面。

在大多数情况下,他们实际上是在相反的方向进行,并告诉他们不应该查看哪些页面。管理页面,后端门户,类别和标签页面等内容,以及网站所有者不希望在搜索引擎上显示的其他内容。这些页面仍然对用户可见,并且拥有权限的任何人(通常是所有人)都可以访问它们。

但是通过告诉那些蜘蛛不要为某些页面建立索引,robots.txt文件可以做到所有人一个忙。如果您在搜索引擎上搜索“ PCPC.me",您是否希望我们的管理页面在排名中显示较高?不会。这对任何人都没有好处,因此我们告诉搜索引擎不要显示它们。它也可以用于阻止搜索引擎检出可能无法帮助他们在搜索结果中对您的网站进行分类的页面。

简而言之,robots.txt会告诉网络抓取者该怎么做。

抓取工具是否会忽略robots.txt文件?是。实际上,许多爬虫 do 都会忽略它。通常,这些爬虫并不是来自信誉良好的搜索引擎。它们来自垃圾邮件发送者,电子邮件收集器以及漫游互联网的其他类型的自动漫游器。请记住这一点,这一点很重要-使用机器人排除标准告诉机器人保持僵持状态并不是有效的安全措施。实际上,某些漫游器可能会以您告诉他们不要访问的页面开始。

但是,搜索引擎将按照您的robots.txt文件所说的那样进行操作格式正确。

如何编写robots.txt文件

机器人排除标准文件中包含几个不同的部分。我将在这里分别对它们进行分解。

在告诉某个机器人它不应该查看哪些页面之前,您必须指定要与之对话的机器人。大多数情况下,您将使用一个简单的声明,表示“所有机器人"。看起来像这样:

User-agent: *星号代表“所有机器人"。不过,您可以为某些机器人。为此,您需要知道要为其制定指南的机器人的名称。可能看起来像这样:

User-agent: Googlebot[list of pages not to crawl]User-agent: Googlebot-Image/1.0[list of pages not to crawl]User-agent: Bingbot[list of pages not to crawl]以此类推。如果发现根本不想爬网的机器人,也可以指定它。

要查找用户代理的名称,请查看useragentstring.com [不再可用]。

这是您的机器人排除文件的主要部分。通过一个简单的声明,您就可以告诉一个机器人或一组机器人不要抓取某些页面。语法很简单。这是您不允许访问网站“ admin"目录中所有内容的方法:

Disallow: /admin/该行将阻止漫游器爬网yoursite.com/admin、yoursite.com/admin/login、yoursite。 com / admin / files / secret.html以及admin目录下的其他任何内容。

要禁止单个页面,只需在禁止行中指定即可:

Disallow: /public/exception.html现在不会绘制“例外"页面,但是将绘制“公共"文件夹中的所有其他内容。

要包含多个目录或页面,只需在后续行中列出它们即可:

Disallow: /private/Disallow: /admin/Disallow: /cgi-bin/Disallow: /temp/这四行内容将适用于您在本节顶部指定的任何用户代理。

如果要防止漫游器查看您网站上的任何页面,请使用以下命令:

Disallow: /如上所述,您可以为不同的漫游器指定某些页面。结合前两个元素,如下所示:

User-agent: googlebotDisallow: /admin/Disallow: /private/User-agent: bingbotDisallow: /admin/Disallow: /private/Disallow: /secret/“ admin"和“ private"部分将在Google和Bing上不可见,但是Google会看到“秘密"目录,而Bing赢得了

您可以使用星号用户代理为所有漫游器指定通用规则,然后在后续部分中也向漫游器提供具体说明。

借助以上知识,您可以编写完整的robots.txt文件。只需启动您喜欢的文本编辑器(我们在这里是Sublime的粉丝),然后开始让机器人知道您的网站的某些部分不欢迎它们。

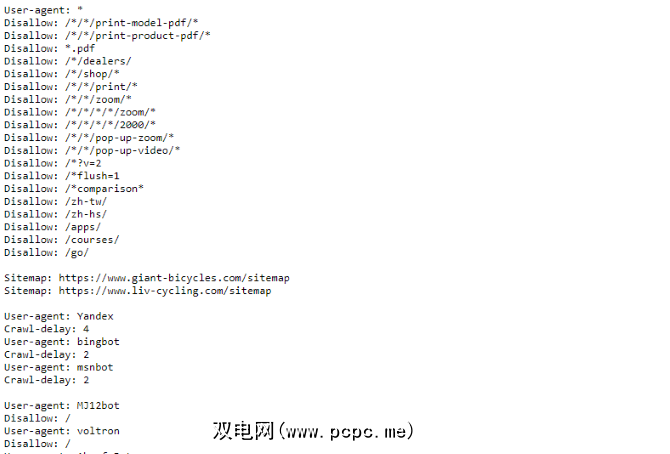

如果您希望看到一个例如robots.txt文件,只需转到任何站点,然后在末尾添加“ /robots.txt"即可。这是“巨型自行车" robots.txt文件的一部分:

如您所见,他们不想在搜索引擎上显示很多页面。它们还包括了一些我们尚未谈论的内容。让我们看一下您的机器人排除文件中还可以做些什么。

查找站点地图

如果robots.txt文件告诉机器人不是要执行此操作,您的站点地图会执行相反的操作,并帮助他们找到所需的内容。虽然搜索引擎可能已经知道您的站点地图了,但是让他们再次知道也无妨。

声明站点地图位置很简单:

Sitemap: [URL of sitemap]就是这样。

在我们自己的robots.txt文件中,它看起来像这样:

Sitemap: //www.PCPC.me/sitemap_index.xml已包含所有内容。

设置抓取延迟

爬网延迟指令告诉某些搜索引擎它们可以多久为您的网站上的页面建立索引。它以秒为单位,尽管某些搜索引擎对它的解释略有不同。有些人认为爬网延迟为5,告诉他们在每次爬网之后等待五秒钟以启动下一个爬网。其他人将其解释为每五秒钟仅爬行一页的指令。

为什么要告诉搜寻器不要尽可能多地爬行?保留带宽。如果您的服务器在努力跟上流量,则可能需要设置爬网延迟。通常,大多数人不必为此担心。但是,大型的高流量网站可能需要尝试一下。

以下是您设置八秒的爬网延迟的方法:

Crawl-delay: 8就是这样。并非所有的搜索引擎都会遵守您的指令。但是问问并没有什么坏处。与禁止页面一样,您可以为特定的搜索引擎设置不同的抓取延迟。

上载robots.txt文件

在文件中设置了所有说明后,可以将其上传到您的网站。确保它是纯文本文件,并且名称为robots.txt。然后将其上传到您的网站,以便可以在yoursite.com/robots.txt上找到它。

如果您使用类似WordPress的内容管理系统,则可能需要采取一种特定的方法。由于每个内容管理系统的不同,因此您需要查阅系统文档。

某些系统可能还具有用于上传文件的在线界面。为此,只需复制并粘贴在先前步骤中创建的文件即可。

记住要更新文件

我最后要提的建议是偶尔查看一下您的文件。机械手排除文件。您的站点发生更改,您可能需要进行一些调整。如果您发现搜索引擎流量发生了奇怪的变化,那么也最好签出该文件。标准符号将来也可能会更改。像您网站上的所有其他内容一样,值得每隔一段时间进行一次检查。

标签: